ChatGPT的致命性缺陷:讓世界越來越模糊

前幾天有人總結了一份ChatGPT自查手冊,里面總結了它的這麼幾個問題,包括, 強詞奪理、編造不存在文本、缺少2023年的一些新數據,等等。

同時,跟ChatGPT類似的幾款AI應用,表現也并不完美。比如,前段時間谷歌的Bard,這是谷歌設計的,對標ChatGPT的智能AI。在測試時就犯了事實性錯誤,咱們前段時間在第43期節目里就說過。再比如,前段時間微軟推出的,由ChatGPT支持的新版必應搜索引擎,也被人指出犯了事實性錯誤。必應在說到一個叫岸田惠理子的日本詩人時,人家的生卒年份本來是1929到2011,而必應給出的答案是1930到2004,直接讓人家少活了8年。再比如說到某公司2022年三季度財報,人家實際運營毛利率是3.9%,但必應的回答是5.9%。注意,這些可都屬于事實性錯誤。

當然,盡管有這些磕磕絆絆,但并不影響大家看好它。

![]()

ChatGPT的致命性缺陷

但是, 有人踩油門,就有人踩剎車。網上對ChatGPT的質疑聲也不少。有人說它會讓人變懶,還有人擔心學生用它來寫論文,等等。但是,在踩剎車的這撥人里,我覺得有一個人的見識非常厲害。這就是著名的華裔科幻作家,特德·姜。也就是,《你一生的故事》的作者,這也是電影《降臨》的原著。

特德·姜認為,我們要想知道,ChatGPT的局限到底是什麼?它又會帶來什麼樣的問題?必須得先了解, ChatGPT的本質到底是什麼?

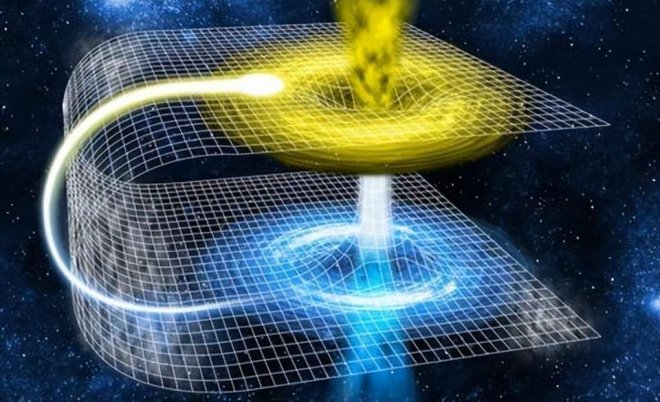

特德·姜說,ChatGPT的本質,是一張互聯網上所有文本的模糊圖像。乍一聽好像很抽象,我先給你講一個故事。這個故事稍微有點難度,我建議你稍微集中點注意力。

2013年的時候,德國的一個建筑公司,在復印房屋平面圖時遇到了一個奇怪的現象。原件的房間面積分別是14.13平方公尺、21.11平方公尺和17.42平方公尺。總之,是三個有零有整,各不相同的數。但是復印出來的圖片,三個房間的面積,都被標記成了14.13平方公尺。

這太奇怪了,明明是復印,怎麼會出錯呢?結果一查,發現問題出在復印機上。當時他們用的復印機,是一種施樂牌的,經常用于建筑圖紙的復印機。這跟咱們平時用的復印機不一樣。因為建筑圖紙往往特別大,直接復印很麻煩。因此這種施樂復印機,是先掃描圖紙原件,然后儲存到本地,再打印出來。你可以這麼理解,它是先記住這個圖像的樣子,再自己畫出來。

這就意味著,施樂復印機,往往要儲存很多圖片文件,而且你知道,建筑圖紙,文件普遍不小。為了節省存儲空間,施樂復印機有一個默認設置,就是給所有文件自動做壓縮處理,把圖片壓縮成更小的文件。

那麼,怎麼才能壓縮得盡量小呢?你可以這麼理解,就像上課,怎麼節省時間?很簡單,重復的東西不學,什麼東西都只學一遍。施樂復印機在壓縮圖片時,就遵循這個原則。假如這棟樓有1000個房間,全都一模一樣,我在識別圖像時,就把它們當成同一個信息,不用重復儲存,只儲存其中的一份就夠了。

沒錯,問題就出在這,這回要復印的三個房間,在施樂復印機看來,是幾乎差不多的。它覺得這些房間之間的差別可以忽略不計。于是就按照同一個房間來識別了。後來,這個bug已經被修復了。

好,故事講完。剛才咱們說了很多,你要是沒太懂也沒關系。只需要記住一句話,因為儲存空間有限,因此機器記東西,有時候不會完全一比一,它們會記一個大概其。也就是, 保留關鍵特征,忽略它們認為不重要的細節。

特德·姜認為,ChatGPT現在做的事,可能就跟施樂復印機有點像。為了節省空間提高效率,它們在回答你的問題時,也是先在網上把資料整合個大概其,然后再用它自己的話告訴你。畢竟,網絡上的素材太多了,它假如全部學習,再轉述給你,不僅自己吃不消,你作為接收者,也會覺得信息冗余。

同時,為了達到一種很智能的感覺,ChatGPT回答問題的方式,往往不是直接引用,而是重新組織信息之后,用非常自然的語言表達出來。這就讓人覺得,它非常智能。就像你衡量一個學生,好學生回答問題的方式肯定不是死記硬背,而是帶上自己的理解。

換句話說,你可以把ChatGPT看成一個特別擅長口語表達,而且效率很高的職業轉述師。這就意味著這麼幾件事。

首先,它是轉述師,而不是專家。它給你的回答不是它原創的,而是學習網絡上其他資料之后的轉述。 其次,為了提升你的接收體驗,它很擅長口語表達。這很容易給你造成一種錯覺,認為它好像真的學會了什麼。最后,為了實現這個口語化的效果,同時,也為了提高效率,它對網上資料的學習,并不是完全一比一地學習,而是學一個大概其。

當然,眼下看,這好像也不是什麼大問題。畢竟,很多人對ChatGPT的當前水平,也沒有那麼嚴格的要求。但是,長期看,特德·姜覺得這可能會帶來兩個問題。

第一,已經經過ChatGPT轉述一次的答案,將來會不會被二次,甚至三次轉述?因為每一次轉述,都是一個大概其,都會忽略一部分細節,轉述的次數多了,被忽視的細節就會越來越多。就好比電腦里的圖片縮略圖,假如再壓縮一次, 會越來越模糊,很多關鍵的事實性信息,可能會丟失。

第二,假如未來整個網絡上,有大量ChatGPT轉述的內容,整個互聯網,可能會變得越來越模糊。你到時再想搜到一點 精確的信息,可能會變難。

注意,特德·姜的這個觀點,目前只是一個假設。怎麼驗證它是否成立?

特德·姜也給了一個方法,就是看下一代升級版的ChatGPT,也就是它的4.0版本,在訓練時,會不會故意排除之前版本生成的內容。也就是,在訓練下一代ChatGPT時,假如用的是網上的原始素材,而且故意排除了之前上一代ChatGPT自己生成的內容。就說明開發者自己已經意識到了這個問題,并且開始解決。

這也間接說明,特德·姜,預測對了。

[圖擷取自網路,如有疑問請私訊]

同時,跟ChatGPT類似的幾款AI應用,表現也并不完美。比如,前段時間谷歌的Bard,這是谷歌設計的,對標ChatGPT的智能AI。在測試時就犯了事實性錯誤,咱們前段時間在第43期節目里就說過。再比如,前段時間微軟推出的,由ChatGPT支持的新版必應搜索引擎,也被人指出犯了事實性錯誤。必應在說到一個叫岸田惠理子的日本詩人時,人家的生卒年份本來是1929到2011,而必應給出的答案是1930到2004,直接讓人家少活了8年。再比如說到某公司2022年三季度財報,人家實際運營毛利率是3.9%,但必應的回答是5.9%。注意,這些可都屬于事實性錯誤。

當然,盡管有這些磕磕絆絆,但并不影響大家看好它。

ChatGPT的致命性缺陷

但是, 有人踩油門,就有人踩剎車。網上對ChatGPT的質疑聲也不少。有人說它會讓人變懶,還有人擔心學生用它來寫論文,等等。但是,在踩剎車的這撥人里,我覺得有一個人的見識非常厲害。這就是著名的華裔科幻作家,特德·姜。也就是,《你一生的故事》的作者,這也是電影《降臨》的原著。

特德·姜認為,我們要想知道,ChatGPT的局限到底是什麼?它又會帶來什麼樣的問題?必須得先了解, ChatGPT的本質到底是什麼?

特德·姜說,ChatGPT的本質,是一張互聯網上所有文本的模糊圖像。乍一聽好像很抽象,我先給你講一個故事。這個故事稍微有點難度,我建議你稍微集中點注意力。

2013年的時候,德國的一個建筑公司,在復印房屋平面圖時遇到了一個奇怪的現象。原件的房間面積分別是14.13平方公尺、21.11平方公尺和17.42平方公尺。總之,是三個有零有整,各不相同的數。但是復印出來的圖片,三個房間的面積,都被標記成了14.13平方公尺。

這太奇怪了,明明是復印,怎麼會出錯呢?結果一查,發現問題出在復印機上。當時他們用的復印機,是一種施樂牌的,經常用于建筑圖紙的復印機。這跟咱們平時用的復印機不一樣。因為建筑圖紙往往特別大,直接復印很麻煩。因此這種施樂復印機,是先掃描圖紙原件,然后儲存到本地,再打印出來。你可以這麼理解,它是先記住這個圖像的樣子,再自己畫出來。

這就意味著,施樂復印機,往往要儲存很多圖片文件,而且你知道,建筑圖紙,文件普遍不小。為了節省存儲空間,施樂復印機有一個默認設置,就是給所有文件自動做壓縮處理,把圖片壓縮成更小的文件。

那麼,怎麼才能壓縮得盡量小呢?你可以這麼理解,就像上課,怎麼節省時間?很簡單,重復的東西不學,什麼東西都只學一遍。施樂復印機在壓縮圖片時,就遵循這個原則。假如這棟樓有1000個房間,全都一模一樣,我在識別圖像時,就把它們當成同一個信息,不用重復儲存,只儲存其中的一份就夠了。

沒錯,問題就出在這,這回要復印的三個房間,在施樂復印機看來,是幾乎差不多的。它覺得這些房間之間的差別可以忽略不計。于是就按照同一個房間來識別了。後來,這個bug已經被修復了。

好,故事講完。剛才咱們說了很多,你要是沒太懂也沒關系。只需要記住一句話,因為儲存空間有限,因此機器記東西,有時候不會完全一比一,它們會記一個大概其。也就是, 保留關鍵特征,忽略它們認為不重要的細節。

特德·姜認為,ChatGPT現在做的事,可能就跟施樂復印機有點像。為了節省空間提高效率,它們在回答你的問題時,也是先在網上把資料整合個大概其,然后再用它自己的話告訴你。畢竟,網絡上的素材太多了,它假如全部學習,再轉述給你,不僅自己吃不消,你作為接收者,也會覺得信息冗余。

同時,為了達到一種很智能的感覺,ChatGPT回答問題的方式,往往不是直接引用,而是重新組織信息之后,用非常自然的語言表達出來。這就讓人覺得,它非常智能。就像你衡量一個學生,好學生回答問題的方式肯定不是死記硬背,而是帶上自己的理解。

換句話說,你可以把ChatGPT看成一個特別擅長口語表達,而且效率很高的職業轉述師。這就意味著這麼幾件事。

首先,它是轉述師,而不是專家。它給你的回答不是它原創的,而是學習網絡上其他資料之后的轉述。 其次,為了提升你的接收體驗,它很擅長口語表達。這很容易給你造成一種錯覺,認為它好像真的學會了什麼。最后,為了實現這個口語化的效果,同時,也為了提高效率,它對網上資料的學習,并不是完全一比一地學習,而是學一個大概其。

當然,眼下看,這好像也不是什麼大問題。畢竟,很多人對ChatGPT的當前水平,也沒有那麼嚴格的要求。但是,長期看,特德·姜覺得這可能會帶來兩個問題。

第一,已經經過ChatGPT轉述一次的答案,將來會不會被二次,甚至三次轉述?因為每一次轉述,都是一個大概其,都會忽略一部分細節,轉述的次數多了,被忽視的細節就會越來越多。就好比電腦里的圖片縮略圖,假如再壓縮一次, 會越來越模糊,很多關鍵的事實性信息,可能會丟失。

第二,假如未來整個網絡上,有大量ChatGPT轉述的內容,整個互聯網,可能會變得越來越模糊。你到時再想搜到一點 精確的信息,可能會變難。

注意,特德·姜的這個觀點,目前只是一個假設。怎麼驗證它是否成立?

特德·姜也給了一個方法,就是看下一代升級版的ChatGPT,也就是它的4.0版本,在訓練時,會不會故意排除之前版本生成的內容。也就是,在訓練下一代ChatGPT時,假如用的是網上的原始素材,而且故意排除了之前上一代ChatGPT自己生成的內容。就說明開發者自己已經意識到了這個問題,并且開始解決。

這也間接說明,特德·姜,預測對了。

[圖擷取自網路,如有疑問請私訊]

|

本篇 |

不想錯過? 請追蹤FB專頁! |

| 喜歡這篇嗎?快分享吧! |

相關文章

科普解密