生成式人工智能正在改變一切,當炒作消失會剩下什麼?

OpenAI 很明顯知道自己在做什麼。2021 年底,只有幾個人的研究小組在 OpenAI 舊金山辦公室討論了一個想法,隨后他們創造了 OpenAI 的文本到圖像模型的新版本:DALL-E。

這是一個可以將簡短的文字描述轉變為圖片的人工智能模型,你可以讓它生成梵高畫的狐貍,或者是披薩做的柯基。

OpenAI 的聯合創始人和 CEO 山姆·奧特曼(Sam Altman)告訴《麻省理工科技評論》:「我們會創造一些新東西,然后我們都必須體驗它一段時間,幾乎總是這樣。我們要試圖弄清楚它將是什麼樣子的,被用于做什麼。」

但這次不行。當他們修改模型時,每個參與其中的人都意識到這是一件特別的事情。「很明顯,這就是我們的產品,」 山姆說,「(這一點)沒有任何爭論,我們甚至從來沒有開會討論過。」

但沒有人能夠預測這款產品將會引起多大的轟動。山姆說:「這是第一個被每個普通用戶帶火的人工智能技術。」

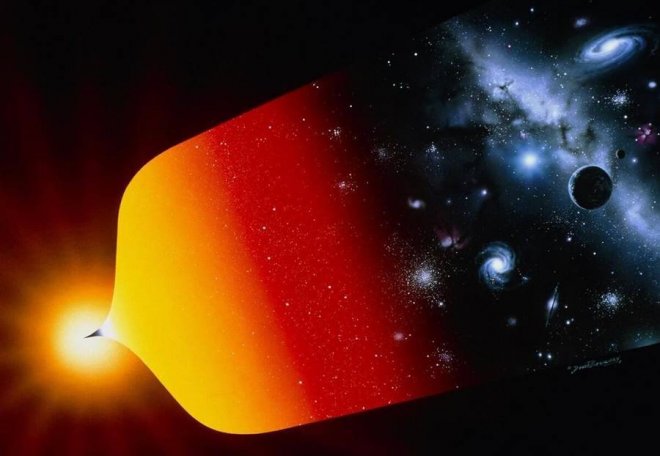

![]()

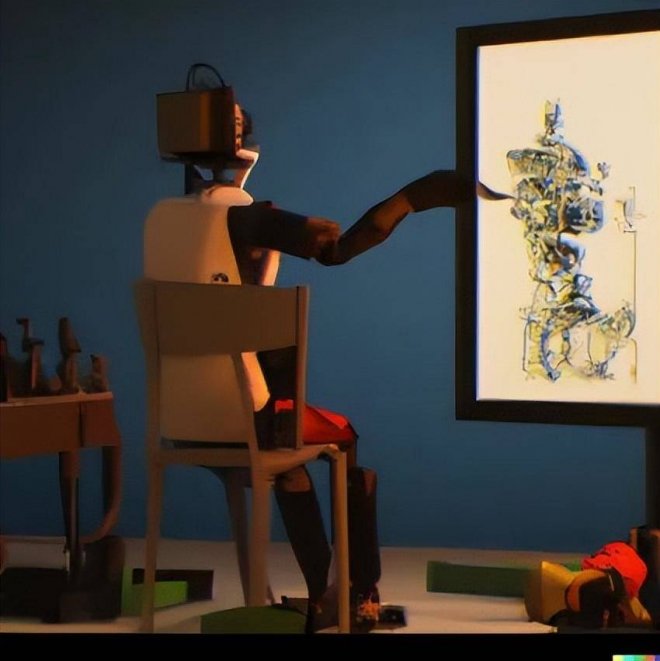

圖 | 數字藝術家 Erik Carter 使用文本到圖像人工智能工具 DALL-E 2,創建這個令人不安的圖像(來源:ERIK CARTER)

DALL-E 2 在 2022 年 4 月發布。5 月,谷歌官宣了(但沒有發布)它自己的兩種文本到圖像的模型,Imagen 和 Parti。

然后是 Midjourney 公司,推出了一個為藝術家制作的文本到圖像模型。8 月,英國初創公司 Stability AI 向公眾免費發布了開源模型 Stable Diffusion。

嘗鮮的用戶蜂擁而至。OpenAI 在短短 2 個半月內就吸引了 100 萬用戶。超過 100 萬人開始通過付費服務 Dream Studio 使用 Stable Diffusion;更多的人通過第三方應用程序使用 Stable Diffusion,或在他們自己的電腦上安裝免費版本。

Stability AI 的創始人易馬德·莫斯塔克(Emad Mostaque)表示,他的目標是擁有 10 億用戶。

在 2022 年 10 月,我們看到了第二輪熱潮:谷歌、Meta 等公司發布了文本到視訊模型,可以創建短視訊、動畫和 3D 圖像。

這種發展速度令人驚訝。在短短幾個月的時間里,這項技術登上了媒體頭條和雜志封面,社交媒體上到處都是討論的人和有關的梗,話題的熱度高居不下,但同時也引發了強烈的反彈。

倫敦國王學院研究計算創造力的人工智能研究員邁克·庫克(Mike Cook)說:「這項技術令人驚嘆,它很有趣,這是新技術該有的樣子。

但它發展得如此之快,以至于在你的理解根本趕不上它的更新速度。我認為,整個社會要花上一段時間來消化它。」

藝術家們陷入了這個時代最大的動蕩之中。有些人會失去工作;有些人會找到新的機會。一些人選擇訴諸法律,因為他們認為,訓練模型所用的圖像被濫用了。

曾在夢工廠等視覺效果工作室工作過的數字藝術家,唐·艾倫·史蒂文森三世(Don Allen Stevenson III)說:「對于像我這樣接受過技術訓練的人來說,這非常可怕的。

「我會說天吶,這是我的全部工作,」他說,「我在使用 DALL-E 的第一個月就陷入了生存危機。」

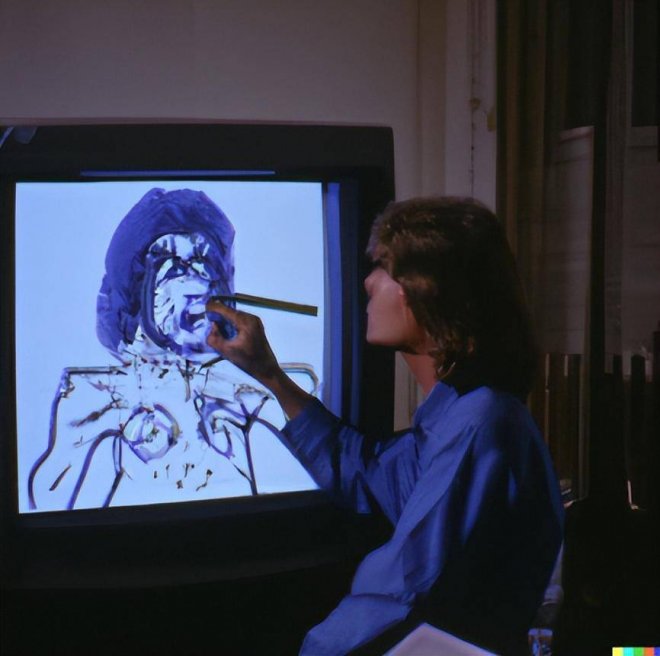

![]()

(來源:ERIK CARTER VIA DALL-E 2)

盡管一些人仍沉浸在震驚之中,但包括史蒂文森在內的許多人正在尋找使用這些工具的方法,并預測接下來會發生什麼。

令人興奮的事實是,我們不知道接下來會發生什麼。原因是,雖然創意產業從娛樂媒體到時尚、建筑、市場營銷等等,將首先感受到影響,但這項技術將把創造力賦予每個人。

從長遠來看,它可以用于產生幾乎任何東西的設計,從新型藥物到服裝和建筑。生成式的革命已經開始。

![]()

神奇的革命

對于曾從事電子游戲和電視節目制作的數字創作者查德·納爾遜(Chad Nelson)來說,從文本到圖像的模型是一個千載難逢的突破。

他說:「這項技術可以讓你在幾秒鐘內將腦海里的靈光一閃變成一個原型。你創造和探索的速度是革命性的——超過了我 30 年來經歷過的任何一個時刻。」

在模型剛出的幾周里,人們就開始使用這些工具進行原型創造和頭腦風暴,從雜志插圖和營銷布局到電子游戲環境和電影概念。

人們制作了同人作品,甚至是整本漫畫書,并在網上不斷分享。山姆甚至用 DALL-E 來設計運動鞋,就在他把設計圖發在推特上之后,有人為他制作了一雙。

紋身藝術師兼計算機科學家艾米·史密斯(Amy Smith)一直在使用 DALL-E 模型來設計紋身。「你可以和客戶一起坐下來,一起進行設計,」她說,「我們正處于一場革命之中。」

數字和視訊藝術家保羅·特里洛(Paul Trillo)認為,這項技術將使關于視覺效果的頭腦風暴更容易、更快速。

「人們都在說,這是特效藝術家或時裝設計師的末日,」他說,「我不認為這是任何職業的終局。相反,我認為它意味著我們不必在晚上和周末加班。」

圖片公司則采取了不同的立場。Getty 已經禁止了人工智能生成的圖像;Shutterstock 公司已經與 OpenAI 簽署了一項協議,將 DALL-E 嵌入其網站,并表示將成立一個基金,對那些成果被模型當作訓練數據的藝術家進行補償。

史蒂文森說,他在動畫工作室制作電影的每一步都嘗試了 DALL-E,包括角色和環境的設計。

有了 DALL-E,他能夠在幾分鐘內完成多個部門的工作。他說:「對于那些因為技術太貴或太復雜而無法從事創造工作的人來說,這是令人振奮的。但如果你不愿意接受改變,那就太可怕了。」

尼爾遜認為未來還會有更多的事情發生。最終,他認為這項技術不僅會被媒體巨頭所接受,也會被建筑和設計公司所接受。不過,他認為人工智能模型還沒有準備好。

「現在就像你有一個小魔法盒子,一個小巫師,」他說。如果你只是想繼續生成圖像,那足夠了,但如果你需要一個創造性的合作伙伴,那還不夠。

他說:「如果我想讓它創造故事和構建世界,它需要對我正在創造的東西有更多的認知。」

這就是問題所在:這些模型仍然不知道自己在做什麼。

![]()

黑盒子

為了了解原因,讓我們看看這些程序是如何工作的。從外部來看,模型是一個黑盒子。

你輸入一段簡短的文字描述,又可以被稱為一段提示,然后等待幾秒鐘,你就會得到一些(或多或少)符合提示的圖像。

你可能不得不調整你的文本,讓模型產生一些更接近你的想法的東西,或者不斷打磨一個偶然得到的結果,這已被稱為「提示工程(prompt engineering)」。

為了獲得最細致的、樣式獨特的圖像,一段描述可以多達幾百個單詞,而選擇正確的單詞已經成為一項有價值的技能。相關的網絡市場如雨后春筍般涌現,專門買賣那些能夠產生理想結果的文字提示和描述。

文字提示可以包含指示模型選擇特定風格的短語,比如「ArtStation 的流行趨勢」,這是在告訴人工智能模仿 ArtStation 網站上流行的圖像(通常是非常詳細的)風格,這個網站上有成千上萬的藝術家展示他們的作品;而「虛幻引擎」則會激活類似電子游戲的圖像風格。

用戶甚至可以輸入特定藝術家的名字,讓人工智能制作出模仿他們風格的仿制品。當然,這讓一些藝術家非常不高興。

![]()

(來源:資料圖)

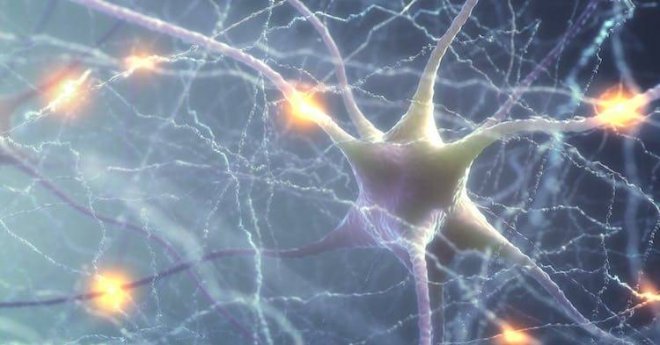

外表之下,文本到圖像模型有兩個關鍵組成部分:一個經過訓練的、將圖像與描述圖像的文本配對的神經網絡,以及另一個被訓練成從零開始生成圖像的神經網絡。其核心思想是讓第二個神經網絡生成能讓第一個神經網絡接受的圖像。

新模型背后的重大突破在于圖像生成的方式。DALL-E 模型的第一個版本使用了 OpenAI 語言模型 GPT-3 背后的技術,通過預測圖像中的下一個像素來生成圖像,就像預測句子中的單詞一樣。這可以實現目的,但效果不好。

「它沒有給人一種神奇的感覺,」山姆說,「它能運轉本身就很神奇了。」

相反,DALL-E 2 模型使用了一種叫做擴散模型(diffusion model)的東西。擴散模型是一種神經網絡,經過訓練后,它可以通過去除訓練過程中添加的像素化噪聲來清理圖像。

這個過程包括拿到一張圖片,改變其中的幾個像素并重復多次,直到原始圖像被擦除,最后你只剩下隨機的像素。

「如果你這樣做一千次,最終圖像看起來就像是沒有信號的電視上面的雪花,」比約恩·歐蒙(Björn Ommer)說。他在德國慕尼黑大學研究生成式人工智能,幫助建立了 Stable Diffusion 背后的擴散模型。

然后訓練一個神經網絡逆轉這個過程,并預測給定圖像的低像素化版本會是什麼樣子。結果是如果你給一個擴散模型一堆像素,它會嘗試生成稍微更干凈的圖像。

把清理后的圖像放回去,模型就會產生更干凈的圖像。當這個過程足夠長,模型就可以把雪花圖像變成高分辨率圖片。

文本到圖像模型的訣竅是,這個過程是由語言模型引導的,該語言模型負責將文字提示與擴散模型產生的圖像相匹配。這將擴散模型推向了語言模型認為的匹配度更高的圖像。

但這些模型并沒有擺脫文本和圖像之間的聯系。如今,大多數文本到圖像的模型都是在一個名為 LAION 的大型數據集上進行訓練的,該數據集包含了從互聯網上提取的數十億組文本和圖像。

這意味著你從文本到圖像模型中得到的圖像,是真實網絡世界的抽象,它包含了被偏見(和[色.情])扭曲的網絡內容。

還有一點值得注意,目前最流行的兩種模型,DALL-E 2 和 Stable Diffusion 之間有一個微小但關鍵的區別。

DALL-E 2 的擴散模型適用于全尺寸圖像,而 Stable Diffusion 則使用了一種由歐蒙和他的同事發明的被稱為「潛在擴散(latent diffusion)」的技術。

后者作用于神經網絡中編碼圖像的壓縮版本,即所謂的「隱空間(latent space)」中,其中只保留了圖像的基本特征。

這意味著 Stable Diffusion 需要的算力更少。與運行在 OpenAI 高性能伺服器上的 DALL-E 2 模型不同,Stable Diffusion 可以在性能尚可的個人電腦上運行。

創造力的爆炸式增長和新應用程序的快速開發,在很大程度上是由于 Stable Diffusion 不僅是開源的,程序員可以自由地改變它,在開源代碼的基礎上構建它并以此賺錢,而且它足夠輕巧,人們在家就能運行。

![]()

重新定義創造力

對一些人來說,這些模型是向通用人工智能(AGI,Artificial general intelligence)邁進的一步。AGI 指的是未來具有通用或甚至類似人類智能的人工智能,當然,你也可以認為它是一個被過度炒作的概念。OpenAI 已經明確了其實現 AGI 的目標。

出于這個原因,OpenAI 的聯合創始人山姆并不關心 DALL-E 2 現在正與大量類似的工具競爭,其中一些是免費的。

「我們是要制造 AGI 的,而不是圖像生成器,」他說,「我們的工具將契合一個更廣泛的產品路線圖。這只是 AGI 能做的一件小事。」

這是一個樂觀的想法,因為許多專家認為,今天的人工智能永遠不會達到那個水平。就基本智能而言,文本到圖像的模型并不比支撐它們的語言模型更智能。

像 GPT-3 和谷歌的 PaLM 這樣的工具,會從他們所訓練的數十億個文檔中獲取文本模式。類似地,DALL-E 和 Stable Diffusion 可能只是復制了在數十億個網絡樣本中發現的文本和圖像之間的關聯。

雖然社交媒體上有許多眼花繚亂的成果,但如果我們不斷嘗試,總會發現不盡如人意的地方。

這些模型會犯下愚蠢的錯誤,比如你想要「河里的鮭魚」,它會生成「漂浮在河上的生魚片」,或者你想要「蝙蝠飛過棒球場」,它會給你一張「有飛行的哺乳動物和一根木棍」的圖片。

這是因為它們所使用的技術,完全不能像人類(甚至大多數動物)那樣理解我們的世界。

即便如此,讓這些模型學習更好的技巧可能只是時間問題。庫克說:「人們說它現在不太擅長做某件事,沒問題,等再燒一億美元之后,它很可能就會做了。」

OpenAI 就是這樣做的。山姆說:「我們已經知道如何讓模型的性能提高 10 倍。我們知道,它在遇到一些邏輯推理任務時會表現很差。我們將列出一個待辦問題清單,然后推出一個新版本來解決當前出現的所有問題。」

如果關于智能和理解的說法被夸大了,那麼創造力呢?就人類而言,我們說藝術家、數學家、企業家、幼兒園的小孩子和他們的老師都是創造力的典范。但要了解這些人的共同之處,是很難的一件事。

對一些人來說,最重要的是結果。另一些人則認為,事物的制造方式,以及在這個過程中的動機——是最重要的。

盡管如此,許多人還是認可瑪格麗特·博登(Margaret Boden)給出的定義。

她是英國蘇塞克斯大學一位有影響力的人工智能研究員和哲學家,她將創造力這個概念歸結為三個關鍵標準:要有創意,一個想法或人工制品需要是新的、令人驚訝的和有價值的。

除此之外,創造性是你第一眼看到就能意識到的東西。「計算創造力(computational creativity)」領域的研究人員將他們的工作描述為:如果使用計算機產生的成果,可以被認為是人類能夠憑一己之力創造出來的東西,那它就會被認為是具有創造性的。

因此,史密斯很高興地稱這種新一代的生成式模型具有創造性,盡管它們會犯一些愚蠢的錯誤。

她說:「很明顯,這些圖像中的創新并不受任何人類輸入的控制。從文本到圖像的轉換往往是令人驚訝和美麗的。」

在澳大利亞莫納什大學研究計算創造力的瑪麗亞·特蕾莎·拉拉諾(Maria Teresa Llano),她同意文本到圖像的模型擴展了以前的定義,但她并不認為它是有創意的。

她指出,當用戶經常使用這些程序時,結果可能會開始變得重復。

這意味著它們沒有完全符合創造力的部分或全部要求,這可能是該技術的一個根本性限制。

本質上,文本到圖像的模型生產出的圖像,依據的是數十億張已經存在的圖像。也許機器學習只會產生(或模仿)它在過去所接觸到的東西的圖像。

這對計算機圖形學來說可能并不重要。Adobe 已經開始在 Photoshop 軟件中加入文本到圖像的生成功能;類似 Photoshop 但開源的 Blender 已經有一個 Stable Diffusion 插件;OpenAI 正在與微軟合作,為 Office 辦公套件開發一個從文本到圖像的小組件。

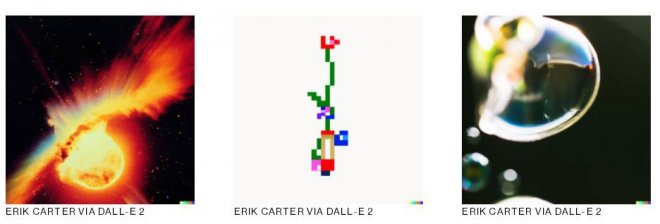

![]()

(來源:ERIK CARTER VIA DALL-E 2)

正是在這種互動中,在這些熟悉的生產力工具的未來版本中,用戶才真正地體會到了影響:來自那些不取代人類創造力,但卻能增強創造力的機器。

「我們今天看到的創造力來自于系統的使用,而不是系統本身,」拉拉諾說道。

這一觀點得到了其他計算創造力研究人員的贊同。這不僅僅關乎于機器所做的事情,更多的是他們是怎麼做的。把他們變成真正的創意伙伴,意味著推動他們更加自主,賦予他們創造性的責任,讓他們去策劃和創造。

許多相關的工具很快就會接踵而至。有人已經編寫了一個叫做 CLIP 詢問器的程序,它可以分析一個圖像,并給出一段用于生成更多類似圖像的提示。

另一些人則在使用機器學習,調整短語和詞匯使得提示的效果更好,讓生成的圖像有更高的品質和保真度——這也有效自動化了提示工程,一個剛出現幾個月的工種。

與此同時,隨著圖像不斷涌現,我們也看到了其他方面的影響。庫克說:「互聯網現在永遠被人工智能制作的圖像污染了。我們在 2022 年制作的圖片,將是從現在開始制作的任何模型的一部分。」

這些工具將對創意產業和整個人工智能領域將產生哪些持久性影響,我們將拭目以待,生成式人工智能已經成為另一種表達工具。

OpenAI聯合創始人山姆說,他現在會在私人短息中使用生成的圖像,就像使用 emoji 表情符號一樣。他說:「我的一些朋友甚至都懶得去生成圖像,他們會直接輸入提示文本。」

但從文本到圖像的模型可能只是一個開始。生成式人工智能最終可能被用于建筑設計和開發之中,這又被稱為「文本到 X(圖片之外的某種事物)」。

「人們會意識到,技術或工藝不再是障礙,唯一的限制是他們的想象力,」納爾遜說。

計算機已經在幾個行業中被使用,以生成大量可能的設計,然后人們會篩選出那些可能有效的設計。

文本到 X 的模型將允許人類設計師從一開始就微調生成過程,使用文字引導計算機跳過無數的選項,以獲得更加令人滿意的結果。

計算機可以召喚出充滿無限可能性的空間,文本到 X 將讓我們用詞匯來探索這些空間。

「我認為這是可以流傳下去的東西,」山姆說。「圖像、視訊、音頻、最終,一切都會被生成。我認為它將會無處不在。」

[圖擷取自網路,如有疑問請私訊]

這是一個可以將簡短的文字描述轉變為圖片的人工智能模型,你可以讓它生成梵高畫的狐貍,或者是披薩做的柯基。

OpenAI 的聯合創始人和 CEO 山姆·奧特曼(Sam Altman)告訴《麻省理工科技評論》:「我們會創造一些新東西,然后我們都必須體驗它一段時間,幾乎總是這樣。我們要試圖弄清楚它將是什麼樣子的,被用于做什麼。」

但這次不行。當他們修改模型時,每個參與其中的人都意識到這是一件特別的事情。「很明顯,這就是我們的產品,」 山姆說,「(這一點)沒有任何爭論,我們甚至從來沒有開會討論過。」

但沒有人能夠預測這款產品將會引起多大的轟動。山姆說:「這是第一個被每個普通用戶帶火的人工智能技術。」

圖 | 數字藝術家 Erik Carter 使用文本到圖像人工智能工具 DALL-E 2,創建這個令人不安的圖像(來源:ERIK CARTER)

DALL-E 2 在 2022 年 4 月發布。5 月,谷歌官宣了(但沒有發布)它自己的兩種文本到圖像的模型,Imagen 和 Parti。

然后是 Midjourney 公司,推出了一個為藝術家制作的文本到圖像模型。8 月,英國初創公司 Stability AI 向公眾免費發布了開源模型 Stable Diffusion。

嘗鮮的用戶蜂擁而至。OpenAI 在短短 2 個半月內就吸引了 100 萬用戶。超過 100 萬人開始通過付費服務 Dream Studio 使用 Stable Diffusion;更多的人通過第三方應用程序使用 Stable Diffusion,或在他們自己的電腦上安裝免費版本。

Stability AI 的創始人易馬德·莫斯塔克(Emad Mostaque)表示,他的目標是擁有 10 億用戶。

在 2022 年 10 月,我們看到了第二輪熱潮:谷歌、Meta 等公司發布了文本到視訊模型,可以創建短視訊、動畫和 3D 圖像。

這種發展速度令人驚訝。在短短幾個月的時間里,這項技術登上了媒體頭條和雜志封面,社交媒體上到處都是討論的人和有關的梗,話題的熱度高居不下,但同時也引發了強烈的反彈。

倫敦國王學院研究計算創造力的人工智能研究員邁克·庫克(Mike Cook)說:「這項技術令人驚嘆,它很有趣,這是新技術該有的樣子。

但它發展得如此之快,以至于在你的理解根本趕不上它的更新速度。我認為,整個社會要花上一段時間來消化它。」

藝術家們陷入了這個時代最大的動蕩之中。有些人會失去工作;有些人會找到新的機會。一些人選擇訴諸法律,因為他們認為,訓練模型所用的圖像被濫用了。

曾在夢工廠等視覺效果工作室工作過的數字藝術家,唐·艾倫·史蒂文森三世(Don Allen Stevenson III)說:「對于像我這樣接受過技術訓練的人來說,這非常可怕的。

「我會說天吶,這是我的全部工作,」他說,「我在使用 DALL-E 的第一個月就陷入了生存危機。」

(來源:ERIK CARTER VIA DALL-E 2)

盡管一些人仍沉浸在震驚之中,但包括史蒂文森在內的許多人正在尋找使用這些工具的方法,并預測接下來會發生什麼。

令人興奮的事實是,我們不知道接下來會發生什麼。原因是,雖然創意產業從娛樂媒體到時尚、建筑、市場營銷等等,將首先感受到影響,但這項技術將把創造力賦予每個人。

從長遠來看,它可以用于產生幾乎任何東西的設計,從新型藥物到服裝和建筑。生成式的革命已經開始。

神奇的革命

對于曾從事電子游戲和電視節目制作的數字創作者查德·納爾遜(Chad Nelson)來說,從文本到圖像的模型是一個千載難逢的突破。

他說:「這項技術可以讓你在幾秒鐘內將腦海里的靈光一閃變成一個原型。你創造和探索的速度是革命性的——超過了我 30 年來經歷過的任何一個時刻。」

在模型剛出的幾周里,人們就開始使用這些工具進行原型創造和頭腦風暴,從雜志插圖和營銷布局到電子游戲環境和電影概念。

人們制作了同人作品,甚至是整本漫畫書,并在網上不斷分享。山姆甚至用 DALL-E 來設計運動鞋,就在他把設計圖發在推特上之后,有人為他制作了一雙。

紋身藝術師兼計算機科學家艾米·史密斯(Amy Smith)一直在使用 DALL-E 模型來設計紋身。「你可以和客戶一起坐下來,一起進行設計,」她說,「我們正處于一場革命之中。」

數字和視訊藝術家保羅·特里洛(Paul Trillo)認為,這項技術將使關于視覺效果的頭腦風暴更容易、更快速。

「人們都在說,這是特效藝術家或時裝設計師的末日,」他說,「我不認為這是任何職業的終局。相反,我認為它意味著我們不必在晚上和周末加班。」

圖片公司則采取了不同的立場。Getty 已經禁止了人工智能生成的圖像;Shutterstock 公司已經與 OpenAI 簽署了一項協議,將 DALL-E 嵌入其網站,并表示將成立一個基金,對那些成果被模型當作訓練數據的藝術家進行補償。

史蒂文森說,他在動畫工作室制作電影的每一步都嘗試了 DALL-E,包括角色和環境的設計。

有了 DALL-E,他能夠在幾分鐘內完成多個部門的工作。他說:「對于那些因為技術太貴或太復雜而無法從事創造工作的人來說,這是令人振奮的。但如果你不愿意接受改變,那就太可怕了。」

尼爾遜認為未來還會有更多的事情發生。最終,他認為這項技術不僅會被媒體巨頭所接受,也會被建筑和設計公司所接受。不過,他認為人工智能模型還沒有準備好。

「現在就像你有一個小魔法盒子,一個小巫師,」他說。如果你只是想繼續生成圖像,那足夠了,但如果你需要一個創造性的合作伙伴,那還不夠。

他說:「如果我想讓它創造故事和構建世界,它需要對我正在創造的東西有更多的認知。」

這就是問題所在:這些模型仍然不知道自己在做什麼。

黑盒子

為了了解原因,讓我們看看這些程序是如何工作的。從外部來看,模型是一個黑盒子。

你輸入一段簡短的文字描述,又可以被稱為一段提示,然后等待幾秒鐘,你就會得到一些(或多或少)符合提示的圖像。

你可能不得不調整你的文本,讓模型產生一些更接近你的想法的東西,或者不斷打磨一個偶然得到的結果,這已被稱為「提示工程(prompt engineering)」。

為了獲得最細致的、樣式獨特的圖像,一段描述可以多達幾百個單詞,而選擇正確的單詞已經成為一項有價值的技能。相關的網絡市場如雨后春筍般涌現,專門買賣那些能夠產生理想結果的文字提示和描述。

文字提示可以包含指示模型選擇特定風格的短語,比如「ArtStation 的流行趨勢」,這是在告訴人工智能模仿 ArtStation 網站上流行的圖像(通常是非常詳細的)風格,這個網站上有成千上萬的藝術家展示他們的作品;而「虛幻引擎」則會激活類似電子游戲的圖像風格。

用戶甚至可以輸入特定藝術家的名字,讓人工智能制作出模仿他們風格的仿制品。當然,這讓一些藝術家非常不高興。

(來源:資料圖)

外表之下,文本到圖像模型有兩個關鍵組成部分:一個經過訓練的、將圖像與描述圖像的文本配對的神經網絡,以及另一個被訓練成從零開始生成圖像的神經網絡。其核心思想是讓第二個神經網絡生成能讓第一個神經網絡接受的圖像。

新模型背后的重大突破在于圖像生成的方式。DALL-E 模型的第一個版本使用了 OpenAI 語言模型 GPT-3 背后的技術,通過預測圖像中的下一個像素來生成圖像,就像預測句子中的單詞一樣。這可以實現目的,但效果不好。

「它沒有給人一種神奇的感覺,」山姆說,「它能運轉本身就很神奇了。」

相反,DALL-E 2 模型使用了一種叫做擴散模型(diffusion model)的東西。擴散模型是一種神經網絡,經過訓練后,它可以通過去除訓練過程中添加的像素化噪聲來清理圖像。

這個過程包括拿到一張圖片,改變其中的幾個像素并重復多次,直到原始圖像被擦除,最后你只剩下隨機的像素。

「如果你這樣做一千次,最終圖像看起來就像是沒有信號的電視上面的雪花,」比約恩·歐蒙(Björn Ommer)說。他在德國慕尼黑大學研究生成式人工智能,幫助建立了 Stable Diffusion 背后的擴散模型。

然后訓練一個神經網絡逆轉這個過程,并預測給定圖像的低像素化版本會是什麼樣子。結果是如果你給一個擴散模型一堆像素,它會嘗試生成稍微更干凈的圖像。

把清理后的圖像放回去,模型就會產生更干凈的圖像。當這個過程足夠長,模型就可以把雪花圖像變成高分辨率圖片。

文本到圖像模型的訣竅是,這個過程是由語言模型引導的,該語言模型負責將文字提示與擴散模型產生的圖像相匹配。這將擴散模型推向了語言模型認為的匹配度更高的圖像。

但這些模型并沒有擺脫文本和圖像之間的聯系。如今,大多數文本到圖像的模型都是在一個名為 LAION 的大型數據集上進行訓練的,該數據集包含了從互聯網上提取的數十億組文本和圖像。

這意味著你從文本到圖像模型中得到的圖像,是真實網絡世界的抽象,它包含了被偏見(和[色.情])扭曲的網絡內容。

還有一點值得注意,目前最流行的兩種模型,DALL-E 2 和 Stable Diffusion 之間有一個微小但關鍵的區別。

DALL-E 2 的擴散模型適用于全尺寸圖像,而 Stable Diffusion 則使用了一種由歐蒙和他的同事發明的被稱為「潛在擴散(latent diffusion)」的技術。

后者作用于神經網絡中編碼圖像的壓縮版本,即所謂的「隱空間(latent space)」中,其中只保留了圖像的基本特征。

這意味著 Stable Diffusion 需要的算力更少。與運行在 OpenAI 高性能伺服器上的 DALL-E 2 模型不同,Stable Diffusion 可以在性能尚可的個人電腦上運行。

創造力的爆炸式增長和新應用程序的快速開發,在很大程度上是由于 Stable Diffusion 不僅是開源的,程序員可以自由地改變它,在開源代碼的基礎上構建它并以此賺錢,而且它足夠輕巧,人們在家就能運行。

重新定義創造力

對一些人來說,這些模型是向通用人工智能(AGI,Artificial general intelligence)邁進的一步。AGI 指的是未來具有通用或甚至類似人類智能的人工智能,當然,你也可以認為它是一個被過度炒作的概念。OpenAI 已經明確了其實現 AGI 的目標。

出于這個原因,OpenAI 的聯合創始人山姆并不關心 DALL-E 2 現在正與大量類似的工具競爭,其中一些是免費的。

「我們是要制造 AGI 的,而不是圖像生成器,」他說,「我們的工具將契合一個更廣泛的產品路線圖。這只是 AGI 能做的一件小事。」

這是一個樂觀的想法,因為許多專家認為,今天的人工智能永遠不會達到那個水平。就基本智能而言,文本到圖像的模型并不比支撐它們的語言模型更智能。

像 GPT-3 和谷歌的 PaLM 這樣的工具,會從他們所訓練的數十億個文檔中獲取文本模式。類似地,DALL-E 和 Stable Diffusion 可能只是復制了在數十億個網絡樣本中發現的文本和圖像之間的關聯。

雖然社交媒體上有許多眼花繚亂的成果,但如果我們不斷嘗試,總會發現不盡如人意的地方。

這些模型會犯下愚蠢的錯誤,比如你想要「河里的鮭魚」,它會生成「漂浮在河上的生魚片」,或者你想要「蝙蝠飛過棒球場」,它會給你一張「有飛行的哺乳動物和一根木棍」的圖片。

這是因為它們所使用的技術,完全不能像人類(甚至大多數動物)那樣理解我們的世界。

即便如此,讓這些模型學習更好的技巧可能只是時間問題。庫克說:「人們說它現在不太擅長做某件事,沒問題,等再燒一億美元之后,它很可能就會做了。」

OpenAI 就是這樣做的。山姆說:「我們已經知道如何讓模型的性能提高 10 倍。我們知道,它在遇到一些邏輯推理任務時會表現很差。我們將列出一個待辦問題清單,然后推出一個新版本來解決當前出現的所有問題。」

如果關于智能和理解的說法被夸大了,那麼創造力呢?就人類而言,我們說藝術家、數學家、企業家、幼兒園的小孩子和他們的老師都是創造力的典范。但要了解這些人的共同之處,是很難的一件事。

對一些人來說,最重要的是結果。另一些人則認為,事物的制造方式,以及在這個過程中的動機——是最重要的。

盡管如此,許多人還是認可瑪格麗特·博登(Margaret Boden)給出的定義。

她是英國蘇塞克斯大學一位有影響力的人工智能研究員和哲學家,她將創造力這個概念歸結為三個關鍵標準:要有創意,一個想法或人工制品需要是新的、令人驚訝的和有價值的。

除此之外,創造性是你第一眼看到就能意識到的東西。「計算創造力(computational creativity)」領域的研究人員將他們的工作描述為:如果使用計算機產生的成果,可以被認為是人類能夠憑一己之力創造出來的東西,那它就會被認為是具有創造性的。

因此,史密斯很高興地稱這種新一代的生成式模型具有創造性,盡管它們會犯一些愚蠢的錯誤。

她說:「很明顯,這些圖像中的創新并不受任何人類輸入的控制。從文本到圖像的轉換往往是令人驚訝和美麗的。」

在澳大利亞莫納什大學研究計算創造力的瑪麗亞·特蕾莎·拉拉諾(Maria Teresa Llano),她同意文本到圖像的模型擴展了以前的定義,但她并不認為它是有創意的。

她指出,當用戶經常使用這些程序時,結果可能會開始變得重復。

這意味著它們沒有完全符合創造力的部分或全部要求,這可能是該技術的一個根本性限制。

本質上,文本到圖像的模型生產出的圖像,依據的是數十億張已經存在的圖像。也許機器學習只會產生(或模仿)它在過去所接觸到的東西的圖像。

這對計算機圖形學來說可能并不重要。Adobe 已經開始在 Photoshop 軟件中加入文本到圖像的生成功能;類似 Photoshop 但開源的 Blender 已經有一個 Stable Diffusion 插件;OpenAI 正在與微軟合作,為 Office 辦公套件開發一個從文本到圖像的小組件。

(來源:ERIK CARTER VIA DALL-E 2)

正是在這種互動中,在這些熟悉的生產力工具的未來版本中,用戶才真正地體會到了影響:來自那些不取代人類創造力,但卻能增強創造力的機器。

「我們今天看到的創造力來自于系統的使用,而不是系統本身,」拉拉諾說道。

這一觀點得到了其他計算創造力研究人員的贊同。這不僅僅關乎于機器所做的事情,更多的是他們是怎麼做的。把他們變成真正的創意伙伴,意味著推動他們更加自主,賦予他們創造性的責任,讓他們去策劃和創造。

許多相關的工具很快就會接踵而至。有人已經編寫了一個叫做 CLIP 詢問器的程序,它可以分析一個圖像,并給出一段用于生成更多類似圖像的提示。

另一些人則在使用機器學習,調整短語和詞匯使得提示的效果更好,讓生成的圖像有更高的品質和保真度——這也有效自動化了提示工程,一個剛出現幾個月的工種。

與此同時,隨著圖像不斷涌現,我們也看到了其他方面的影響。庫克說:「互聯網現在永遠被人工智能制作的圖像污染了。我們在 2022 年制作的圖片,將是從現在開始制作的任何模型的一部分。」

這些工具將對創意產業和整個人工智能領域將產生哪些持久性影響,我們將拭目以待,生成式人工智能已經成為另一種表達工具。

OpenAI聯合創始人山姆說,他現在會在私人短息中使用生成的圖像,就像使用 emoji 表情符號一樣。他說:「我的一些朋友甚至都懶得去生成圖像,他們會直接輸入提示文本。」

但從文本到圖像的模型可能只是一個開始。生成式人工智能最終可能被用于建筑設計和開發之中,這又被稱為「文本到 X(圖片之外的某種事物)」。

「人們會意識到,技術或工藝不再是障礙,唯一的限制是他們的想象力,」納爾遜說。

計算機已經在幾個行業中被使用,以生成大量可能的設計,然后人們會篩選出那些可能有效的設計。

文本到 X 的模型將允許人類設計師從一開始就微調生成過程,使用文字引導計算機跳過無數的選項,以獲得更加令人滿意的結果。

計算機可以召喚出充滿無限可能性的空間,文本到 X 將讓我們用詞匯來探索這些空間。

「我認為這是可以流傳下去的東西,」山姆說。「圖像、視訊、音頻、最終,一切都會被生成。我認為它將會無處不在。」

[圖擷取自網路,如有疑問請私訊]

|

本篇 |

不想錯過? 請追蹤FB專頁! |

| 喜歡這篇嗎?快分享吧! |

相關文章

科普解密