科技巨頭血拼:微軟豪擲數億造ChatGPT超算,谷歌加急測試Big Bard

成本雖然高昂,但巨頭們更不愿錯過這次機會。

近幾個月,ChatGPT 爆火出圈,風頭無兩。人們大多把關注重點放在了 ChatGPT 強大的生成功能和應用場景上,卻很少關心模型的應用成本。

雖然 ChatGPT API 開放之后,使用成本降低了九成,但對于 OpenAI 和集成 ChatGPT 的科技公司來說,情況卻大不相同。

眾所周知,在谷歌搜索的時代,搜索引擎的工作原理是建立巨大的網絡索引,在用戶進行搜索時,這些索引條目會被掃描、排名和分類,隨后結果顯示出最相關的條目。谷歌的搜索結果頁面實際上會告訴用戶搜索所需要的時間(通常不到一秒)。

而 ChatGPT 式的搜索引擎會在每次搜索時啟動一個模仿人腦的巨大神經網絡,生成一堆文本,可能還會查詢大型搜索索引以獲取事實信息。這意味著用戶與其交互的時間可能遠遠超過幾分之一秒,并且這些額外的處理需要花費更多的成本。

據路透社報道,Alphabet(谷歌的母公司)的董事長 John Hennessy 及幾位分析師交談之后寫道:「與 AI 大型語言模型交流詢問的成本可能是標準關鍵字搜索的 10 倍以上」。對于致力于推行 ChatGPT 式搜索引擎的谷歌、微軟來說,這可能意味著「數十億美元的額外成本」。

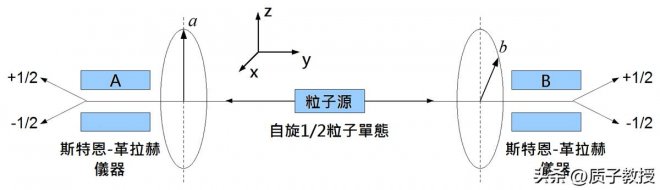

![]()

Alphabet 董事長 John Hennessy。

雖然 ChatGPT 這個研發熱點肯定是要跟的,但付出的成本是各家公司能夠承擔的嗎?

微軟:上萬塊 A100,為 OpenAI 造超算

微軟的答案是肯定的,而且它還要進一步增加相關的研發投入。

彭博社報道,微軟花費了數億美元為 OpenAI 建造了一台巨大的超級計算機,使用了「成千上萬塊 GPU」以推動 OpenAI 的 ChatGPT 聊天機器人。

據彭博社獲得的回復,微軟人工智能和云計算副總裁 Scott Guthrie 說,公司在該項目上花費了數億美元的資金。雖然這對微軟來說可能不值一提,畢竟它最近延長了對 OpenAI 的多年、數十億美元的投資,但這無疑表明,微軟愿意在人工智能領域投入更多資金。

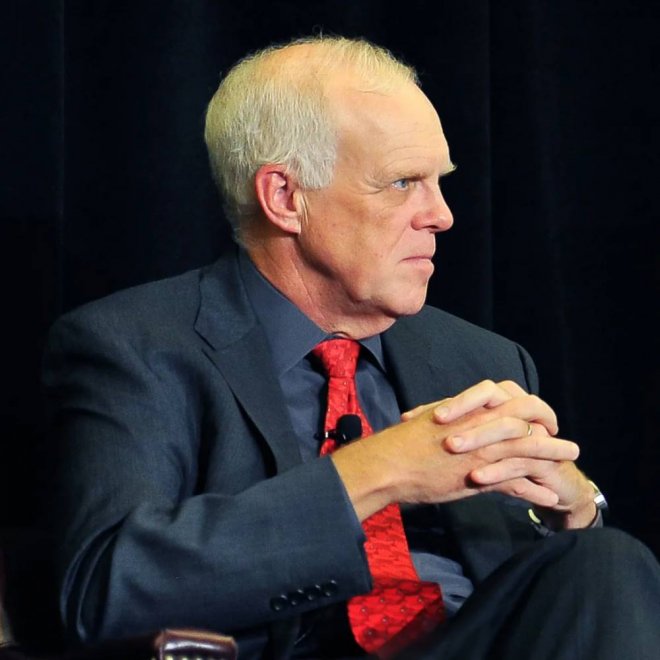

在本周一的博客中,微軟介紹了它是如何創建 OpenAI 使用的強大的 Azure 人工智能基礎設施,以及其系統如何變得更加強大。

![]()

比如微軟推出了新的虛擬機 —— 使用英偉達 H100 和 A100 Tensor Core GPU 以及 Quantum-2 InfiniBand 網絡,這是兩家公司去年就預告過的項目。這將允許 OpenAI 和其他依賴 Azure 的公司訓練更大、更復雜的 AI 模型。

「大約五年前,OpenAI 向微軟提出了一個大膽的想法,即它可以構建將永遠改變人們與計算機交互方式的人工智能系統。」John Roach 寫道。

當時,沒有人知道這將意味著什麼。現在,我們理解了這種設想 ——ChatGPT,并體驗到了它的魔力:AI 系統可以創建人們用簡單語言描述的任何圖片,聊天機器人可以根據少量單詞編寫說唱歌詞、起草電子郵件和規劃整個菜單。

像這樣的技術,在當時看來未必不可能。只是為了構建它,OpenAI 需要真正大規模的計算能力。

2019 年,微軟公司宣布向 OpenAI 投資 10 億美元,同意為這家 AI 研究初創公司建造一台大規模的前沿超級計算機。當時唯一的問題是:微軟沒有 OpenAI 所需要的東西,也不完全確定能在自己的 Azure 云服務中建造這麼大的東西而不崩潰。現在,這個承諾終于兌現了。

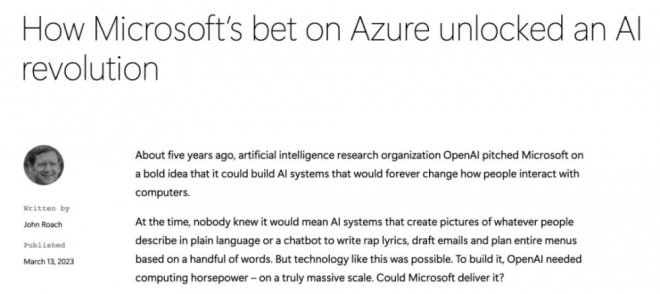

微軟表示,為了建立給 OpenAI 項目提供動力的超級計算機,它在 Azure 云計算平台上「將成千上萬的英偉達 GPU 連接在一起」。反過來,這使得 OpenAI 能夠訓練出越來越強大的模型,并「釋放出 AI 能力」,比如 ChatGPT 和必應工具。

![]()

這些突破的關鍵是學習如何構建、操作和維護數萬個在高吞吐量、低延遲 InfiniBand 網絡上相互連接的共置 GPU。這個規模甚至比 GPU 和網絡設備供應商測試過的還要大。這是一片未知的領域,沒有人確切知道硬件是否可以在不損壞的情況下被推到那麼遠。為了訓練一個大型語言模型,計算工作量被分配到一個集群中的數千個 GPU 上。在計算的某些階段(稱為 allreduce),GPU 會交換有關它們已完成工作的信息。InfiniBand 網絡加速了這一階段,該階段必須在 GPU 開始下一個計算塊之前完成。

「我們看到的是,我們將需要建立專注于實現大型訓練工作負載的特殊用途集群,而 OpenAI 是這一點的早期證明之一,」微軟 Azure AI 企業副總裁 Eric Boyd 在一份聲明中說。「我們與他們緊密合作,了解他們在建立訓練環境時尋找的、需要的關鍵是什麼。」

谷歌:加緊內測 Big Bard

相比于微軟,谷歌的搜索成本問題無疑更大。微軟之所以如此渴望撼動谷歌搜索引擎,部分原因就是在大多數市場份額估計中,必應只占全球搜索市場的 3%,而谷歌約占 93%。搜索是谷歌的主要業務,而微軟并不需要擔心這一點。

根據 Morgan Stanley 的估算 —— 假設「類 ChatGPT 的 AI 能夠用 50 個詞(word)的答案處理一半的查詢」,谷歌每年的成本將增加 60 億美元。

![]()

有趣的是,谷歌從一開始就對模型規模持謹慎態度。谷歌表示 Bard 聊天機器人最初發布的是 LaMDA 輕量級模型版本,原因是「這個更小的模型需要更少的計算能力,才能夠擴展到更多的用戶,得到更多的反饋。」要知道這不是谷歌的常見操作,谷歌經常在模型規模方面讓其他公司相形見絀,在計算資源方面也是極具優勢。「規模」只是谷歌花點錢就能解決的問題,除非成本增加的不是一點半點。

根據 Insider 的最新消息,谷歌正在測試一個名為 Big Bard 的模型,它是 Bard 的高級版本,使用了與 Bard 相同的語言模型 LaMDA。

根據內測示例顯示,對于相同的問題,Big Bard 給出了更豐富、更人性化的回答,它通常也更健談、更隨意。不過不是所有員工都可以內測 Big Bard ,它是有限制的,僅供部分員工使用,而 Bard 則對所有谷歌員工開放。

除此以外,Big Bard 使用更大規模的 LaMDA,AI 技術為其聊天機器人提供支持。谷歌表示 Big Bard 是其在布局對話模型計劃中的一部分,該計劃旨在創建一個通用聊天機器人,可以回答用戶在其產品和服務中提出的任何問題或請求。

出于成本考慮,谷歌可能會推出 Bard 的限量版。然而,這場人工智能競賽并沒有放緩的跡象。上周有消息傳出,多模態的 GPT-4 將于本周發布。看來微軟和谷歌的對打一時半會兒還停不下來。

商業模式如何跑通?

類 ChatGPT 產品能為科技公司帶來多大的收益,目前很難衡量。有一個已知的例子,谷歌和亞馬遜的語音助手多年來一直保持「以后再想辦法」的盈利思路,目前都未能產生利潤,而且它們是比 ChatGPT 更受限制的聊天機器人。OpenAI 在開放 ChatGPT API 之后,以 token 為單位收取費用,但這對搜索引擎來說并不適用。

微軟方面已經準備「在必應聊天機器人生成的回復中[插·入]廣告」,補償其高昂的伺服器運行成本。

在開放 API 之后,越來越多的企業用戶將與 OpenAI 合作,將其 ChatGPT 服務集成到自己的產品中。大多數公司使用 ChatGPT 等大型語言模型來幫助客戶制作企業博客、營銷電子郵件等等,而工作量比以前少得多。然而,這些公司的產品幾乎都是給大型語言模型套了一個簡單的「外殼」,因此很難實現差異化競爭優勢。

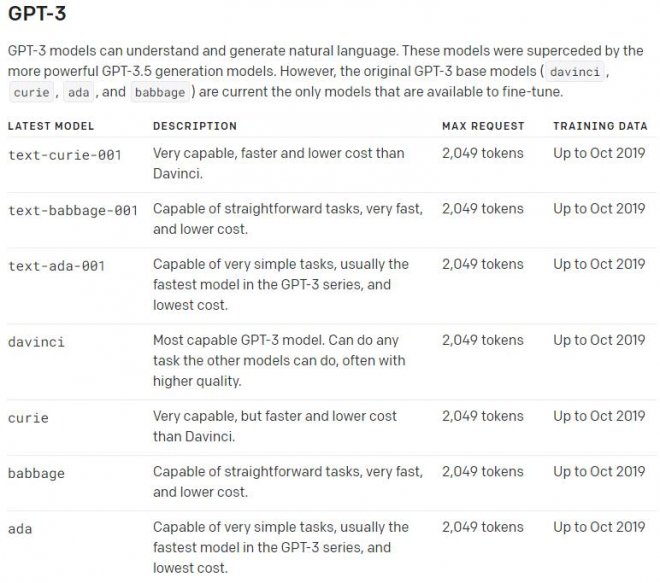

實際上,OpenAI 最近還推出了 4 個 GPT-3 模型 ——Davinci、Curie、Babbage 和 Ada。其中 Davinci 是功能最強大的模型,Ada 則是速度最快的。Davinci 被一些公司認為是開發產品的更好選擇,它的輸出往往比 ChatGPT 的更簡潔、更直接,并且在某些類別的 prompt 下也表現更好。而 ChatGPT 在一些關鍵領域優于 Davinci,包括數學、情緒分析等等。

![]()

值得注意的是,OpenAI 為 Davinci API 設置的定價是 ChatGPT 的十倍。因此近幾周內,大多數 Davinci 用戶可能會涌向 ChatGPT。對于 OpenAI 和其競爭對手(包括 Cohere、AI21、Anthropic、Hugging Face)來說,Davinci 的定價似乎更加合理。至于 ChatGPT,它的超低定價會讓行業內的同類產品價格大幅下跌,包括 OpenAI 自己的產品。

將 ChatGPT API 的價格設置得如此低的水平(只有原來的十分之一)之后,很難說 OpenAI 會從 ChatGPT 或其他任何模型中獲利還是虧損,因為這些超大規模的模型查詢成本非常高。有人猜測:OpenAI 可能已經通過剔除自 11 月首次亮相以來全世界提出的無數 ChatGPT 查詢中很少激活的參數,修剪了支持 ChatGPT 的模型以降低模型成本。但這只是一個猜測。

接下來的一段時間,OpenAI 可能會因為 ChatGPT 被大量使用而虧損。這聽起來有點反直覺,但大型語言模型的訓練和運行成本確實非常高。但對于獲得微軟 100 億美元和 GPU 全力支持的 OpenAI 來說,「薄利多銷」也能讓它比其他競爭對手走得更遠。

[圖擷取自網路,如有疑問請私訊]

近幾個月,ChatGPT 爆火出圈,風頭無兩。人們大多把關注重點放在了 ChatGPT 強大的生成功能和應用場景上,卻很少關心模型的應用成本。

雖然 ChatGPT API 開放之后,使用成本降低了九成,但對于 OpenAI 和集成 ChatGPT 的科技公司來說,情況卻大不相同。

眾所周知,在谷歌搜索的時代,搜索引擎的工作原理是建立巨大的網絡索引,在用戶進行搜索時,這些索引條目會被掃描、排名和分類,隨后結果顯示出最相關的條目。谷歌的搜索結果頁面實際上會告訴用戶搜索所需要的時間(通常不到一秒)。

而 ChatGPT 式的搜索引擎會在每次搜索時啟動一個模仿人腦的巨大神經網絡,生成一堆文本,可能還會查詢大型搜索索引以獲取事實信息。這意味著用戶與其交互的時間可能遠遠超過幾分之一秒,并且這些額外的處理需要花費更多的成本。

據路透社報道,Alphabet(谷歌的母公司)的董事長 John Hennessy 及幾位分析師交談之后寫道:「與 AI 大型語言模型交流詢問的成本可能是標準關鍵字搜索的 10 倍以上」。對于致力于推行 ChatGPT 式搜索引擎的谷歌、微軟來說,這可能意味著「數十億美元的額外成本」。

Alphabet 董事長 John Hennessy。

雖然 ChatGPT 這個研發熱點肯定是要跟的,但付出的成本是各家公司能夠承擔的嗎?

微軟:上萬塊 A100,為 OpenAI 造超算

微軟的答案是肯定的,而且它還要進一步增加相關的研發投入。

彭博社報道,微軟花費了數億美元為 OpenAI 建造了一台巨大的超級計算機,使用了「成千上萬塊 GPU」以推動 OpenAI 的 ChatGPT 聊天機器人。

據彭博社獲得的回復,微軟人工智能和云計算副總裁 Scott Guthrie 說,公司在該項目上花費了數億美元的資金。雖然這對微軟來說可能不值一提,畢竟它最近延長了對 OpenAI 的多年、數十億美元的投資,但這無疑表明,微軟愿意在人工智能領域投入更多資金。

在本周一的博客中,微軟介紹了它是如何創建 OpenAI 使用的強大的 Azure 人工智能基礎設施,以及其系統如何變得更加強大。

比如微軟推出了新的虛擬機 —— 使用英偉達 H100 和 A100 Tensor Core GPU 以及 Quantum-2 InfiniBand 網絡,這是兩家公司去年就預告過的項目。這將允許 OpenAI 和其他依賴 Azure 的公司訓練更大、更復雜的 AI 模型。

「大約五年前,OpenAI 向微軟提出了一個大膽的想法,即它可以構建將永遠改變人們與計算機交互方式的人工智能系統。」John Roach 寫道。

當時,沒有人知道這將意味著什麼。現在,我們理解了這種設想 ——ChatGPT,并體驗到了它的魔力:AI 系統可以創建人們用簡單語言描述的任何圖片,聊天機器人可以根據少量單詞編寫說唱歌詞、起草電子郵件和規劃整個菜單。

像這樣的技術,在當時看來未必不可能。只是為了構建它,OpenAI 需要真正大規模的計算能力。

2019 年,微軟公司宣布向 OpenAI 投資 10 億美元,同意為這家 AI 研究初創公司建造一台大規模的前沿超級計算機。當時唯一的問題是:微軟沒有 OpenAI 所需要的東西,也不完全確定能在自己的 Azure 云服務中建造這麼大的東西而不崩潰。現在,這個承諾終于兌現了。

微軟表示,為了建立給 OpenAI 項目提供動力的超級計算機,它在 Azure 云計算平台上「將成千上萬的英偉達 GPU 連接在一起」。反過來,這使得 OpenAI 能夠訓練出越來越強大的模型,并「釋放出 AI 能力」,比如 ChatGPT 和必應工具。

這些突破的關鍵是學習如何構建、操作和維護數萬個在高吞吐量、低延遲 InfiniBand 網絡上相互連接的共置 GPU。這個規模甚至比 GPU 和網絡設備供應商測試過的還要大。這是一片未知的領域,沒有人確切知道硬件是否可以在不損壞的情況下被推到那麼遠。為了訓練一個大型語言模型,計算工作量被分配到一個集群中的數千個 GPU 上。在計算的某些階段(稱為 allreduce),GPU 會交換有關它們已完成工作的信息。InfiniBand 網絡加速了這一階段,該階段必須在 GPU 開始下一個計算塊之前完成。

「我們看到的是,我們將需要建立專注于實現大型訓練工作負載的特殊用途集群,而 OpenAI 是這一點的早期證明之一,」微軟 Azure AI 企業副總裁 Eric Boyd 在一份聲明中說。「我們與他們緊密合作,了解他們在建立訓練環境時尋找的、需要的關鍵是什麼。」

谷歌:加緊內測 Big Bard

相比于微軟,谷歌的搜索成本問題無疑更大。微軟之所以如此渴望撼動谷歌搜索引擎,部分原因就是在大多數市場份額估計中,必應只占全球搜索市場的 3%,而谷歌約占 93%。搜索是谷歌的主要業務,而微軟并不需要擔心這一點。

根據 Morgan Stanley 的估算 —— 假設「類 ChatGPT 的 AI 能夠用 50 個詞(word)的答案處理一半的查詢」,谷歌每年的成本將增加 60 億美元。

有趣的是,谷歌從一開始就對模型規模持謹慎態度。谷歌表示 Bard 聊天機器人最初發布的是 LaMDA 輕量級模型版本,原因是「這個更小的模型需要更少的計算能力,才能夠擴展到更多的用戶,得到更多的反饋。」要知道這不是谷歌的常見操作,谷歌經常在模型規模方面讓其他公司相形見絀,在計算資源方面也是極具優勢。「規模」只是谷歌花點錢就能解決的問題,除非成本增加的不是一點半點。

根據 Insider 的最新消息,谷歌正在測試一個名為 Big Bard 的模型,它是 Bard 的高級版本,使用了與 Bard 相同的語言模型 LaMDA。

根據內測示例顯示,對于相同的問題,Big Bard 給出了更豐富、更人性化的回答,它通常也更健談、更隨意。不過不是所有員工都可以內測 Big Bard ,它是有限制的,僅供部分員工使用,而 Bard 則對所有谷歌員工開放。

除此以外,Big Bard 使用更大規模的 LaMDA,AI 技術為其聊天機器人提供支持。谷歌表示 Big Bard 是其在布局對話模型計劃中的一部分,該計劃旨在創建一個通用聊天機器人,可以回答用戶在其產品和服務中提出的任何問題或請求。

出于成本考慮,谷歌可能會推出 Bard 的限量版。然而,這場人工智能競賽并沒有放緩的跡象。上周有消息傳出,多模態的 GPT-4 將于本周發布。看來微軟和谷歌的對打一時半會兒還停不下來。

商業模式如何跑通?

類 ChatGPT 產品能為科技公司帶來多大的收益,目前很難衡量。有一個已知的例子,谷歌和亞馬遜的語音助手多年來一直保持「以后再想辦法」的盈利思路,目前都未能產生利潤,而且它們是比 ChatGPT 更受限制的聊天機器人。OpenAI 在開放 ChatGPT API 之后,以 token 為單位收取費用,但這對搜索引擎來說并不適用。

微軟方面已經準備「在必應聊天機器人生成的回復中[插·入]廣告」,補償其高昂的伺服器運行成本。

在開放 API 之后,越來越多的企業用戶將與 OpenAI 合作,將其 ChatGPT 服務集成到自己的產品中。大多數公司使用 ChatGPT 等大型語言模型來幫助客戶制作企業博客、營銷電子郵件等等,而工作量比以前少得多。然而,這些公司的產品幾乎都是給大型語言模型套了一個簡單的「外殼」,因此很難實現差異化競爭優勢。

實際上,OpenAI 最近還推出了 4 個 GPT-3 模型 ——Davinci、Curie、Babbage 和 Ada。其中 Davinci 是功能最強大的模型,Ada 則是速度最快的。Davinci 被一些公司認為是開發產品的更好選擇,它的輸出往往比 ChatGPT 的更簡潔、更直接,并且在某些類別的 prompt 下也表現更好。而 ChatGPT 在一些關鍵領域優于 Davinci,包括數學、情緒分析等等。

值得注意的是,OpenAI 為 Davinci API 設置的定價是 ChatGPT 的十倍。因此近幾周內,大多數 Davinci 用戶可能會涌向 ChatGPT。對于 OpenAI 和其競爭對手(包括 Cohere、AI21、Anthropic、Hugging Face)來說,Davinci 的定價似乎更加合理。至于 ChatGPT,它的超低定價會讓行業內的同類產品價格大幅下跌,包括 OpenAI 自己的產品。

將 ChatGPT API 的價格設置得如此低的水平(只有原來的十分之一)之后,很難說 OpenAI 會從 ChatGPT 或其他任何模型中獲利還是虧損,因為這些超大規模的模型查詢成本非常高。有人猜測:OpenAI 可能已經通過剔除自 11 月首次亮相以來全世界提出的無數 ChatGPT 查詢中很少激活的參數,修剪了支持 ChatGPT 的模型以降低模型成本。但這只是一個猜測。

接下來的一段時間,OpenAI 可能會因為 ChatGPT 被大量使用而虧損。這聽起來有點反直覺,但大型語言模型的訓練和運行成本確實非常高。但對于獲得微軟 100 億美元和 GPU 全力支持的 OpenAI 來說,「薄利多銷」也能讓它比其他競爭對手走得更遠。

[圖擷取自網路,如有疑問請私訊]

|

本篇 |

不想錯過? 請追蹤FB專頁! |

| 喜歡這篇嗎?快分享吧! |

相關文章

科普解密