AI自給自足!用合成數據做訓練,效果比真實數據還好丨ICLR 2023

AI生成的圖像太逼真,為什麼不能拿來訓練AI呢?

可別說,現在還真有人這麼做了。

來自香港大學、牛津大學和字節跳動的幾名研究人員,決定嘗試一下能否使用高品質AI合成圖片,來提升 圖像分類模型的性能。

為了避免AI合成的圖像過于單一、或是品質不穩定,他們還提出了幾類提升數據多樣性和可靠性的方法,幫助AI合成更好的數據集(來喂給AI的同類doge)。

結果他們發現,不僅效果不錯,有的AI在訓練后,效果竟然 比用真實數據訓練還要好!

![]()

目前這篇論文已經被ICLR 2023收錄。

![]()

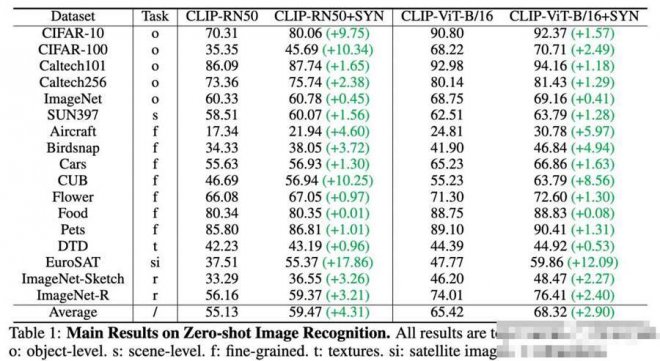

把AI生成的數據喂給AI作者們分別從零樣本(zero-shot)、少樣本(few-shot)圖像分類、模型預訓練(pre-training)與遷移學習三個⽅⾯進⾏了探討,并給出了提升數據多樣性與可靠性的方法。

零樣本圖像分類零樣本(Zero-shot)圖像分類任務,指沒有任何⽬標類別的訓練圖⽚,只有對⽬標類別的描述。

作者們先是提出了一種名為 語言增強(Language Enhancement,LE)的⽅法,用于增強合成數據多樣性。

具體來說,這種方法會給標簽「擴句」,如果原標簽是簡單的「飛機」,那麼經過「擴句」后的提示詞就會變成「一架盤旋在海灘和城市上空的白色飛機」。

隨后,還采用了一種叫做 CLIP過濾器(CLIP Filter)的⽅法確保合成數據的可靠性,即過濾掉合成品質不行的圖片,確保AI數據品質過硬。

在17個數據集上,相⽐此前效果最好的CLIP模型,相關⼤⼩模型均獲得了顯著提升(4.31%/2.90%),展示了合成數據的有效性。

![]()

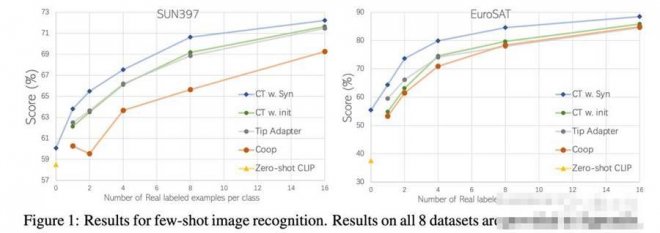

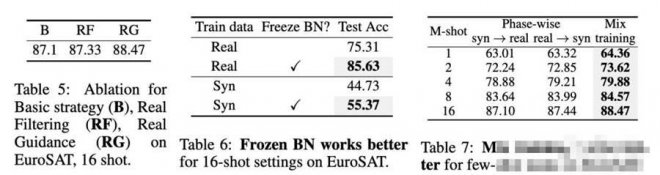

少樣本圖像分類少樣本圖像(Few-shot)分類任務,通常僅有極少數量(1~16張)的⽬標類別圖⽚,與零樣本任務的區別是增加了類別與任務特定領域信息。

因此,作者們決定將域內數據(in-domain)的知識⽤于圖像⽣成,即將少量的⽬標類別圖⽚⽤于噪聲疊加的初始狀態(Real Guidance),進⼀步發揮⽣成模型的能⼒,從而進⼀步提升性能。

![]()

![]()

預訓練與遷移學習模型預訓練(pre-training)任務,即將模型在⼤量數據上進⾏訓練,將訓練后的模型作為「起始點」,來幫助提升下游任務的性能。

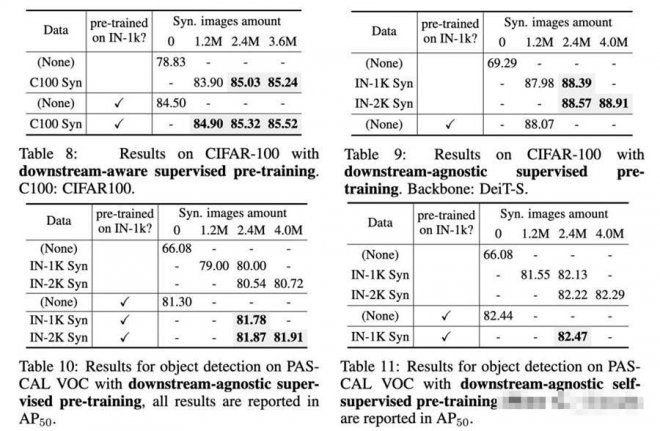

作者們利⽤合成數據,對模型進⾏了預訓練,并對數據量、數據多樣性程度、預訓練模型結構和預訓練⽅法進⾏了實驗研究。

最終發現:

⽤合成數據進⾏預訓練。已經可以 達到甚⾄超越⽤真實數據預訓練的效果。 ⽤更⼤的數據量和數據多樣性的合成數據,可以獲得更好的預訓練效果。 從模型結構和預訓練⽅法來看,ViT-based模型(相比convolutional-based模型)、⾃監督⽅法(相比有監督⽅法)會更適合合成數據下的預訓練。

![]()

論文認為,利⽤⽣成模型產⽣的合成數據來幫助圖像分類任務是可行的,不過也存在⼀定的局限性。

例如,如何處理特定任務的domain gap和數據多樣性之間的trade-off,以及如何更有效地利⽤潛在⽆窮量的合成圖⽚⽤于預訓練,都是需要進一步去解決的問題。

[圖擷取自網路,如有疑問請私訊]

可別說,現在還真有人這麼做了。

來自香港大學、牛津大學和字節跳動的幾名研究人員,決定嘗試一下能否使用高品質AI合成圖片,來提升 圖像分類模型的性能。

為了避免AI合成的圖像過于單一、或是品質不穩定,他們還提出了幾類提升數據多樣性和可靠性的方法,幫助AI合成更好的數據集(來喂給AI的同類doge)。

結果他們發現,不僅效果不錯,有的AI在訓練后,效果竟然 比用真實數據訓練還要好!

目前這篇論文已經被ICLR 2023收錄。

把AI生成的數據喂給AI作者們分別從零樣本(zero-shot)、少樣本(few-shot)圖像分類、模型預訓練(pre-training)與遷移學習三個⽅⾯進⾏了探討,并給出了提升數據多樣性與可靠性的方法。

零樣本圖像分類零樣本(Zero-shot)圖像分類任務,指沒有任何⽬標類別的訓練圖⽚,只有對⽬標類別的描述。

作者們先是提出了一種名為 語言增強(Language Enhancement,LE)的⽅法,用于增強合成數據多樣性。

具體來說,這種方法會給標簽「擴句」,如果原標簽是簡單的「飛機」,那麼經過「擴句」后的提示詞就會變成「一架盤旋在海灘和城市上空的白色飛機」。

隨后,還采用了一種叫做 CLIP過濾器(CLIP Filter)的⽅法確保合成數據的可靠性,即過濾掉合成品質不行的圖片,確保AI數據品質過硬。

在17個數據集上,相⽐此前效果最好的CLIP模型,相關⼤⼩模型均獲得了顯著提升(4.31%/2.90%),展示了合成數據的有效性。

少樣本圖像分類少樣本圖像(Few-shot)分類任務,通常僅有極少數量(1~16張)的⽬標類別圖⽚,與零樣本任務的區別是增加了類別與任務特定領域信息。

因此,作者們決定將域內數據(in-domain)的知識⽤于圖像⽣成,即將少量的⽬標類別圖⽚⽤于噪聲疊加的初始狀態(Real Guidance),進⼀步發揮⽣成模型的能⼒,從而進⼀步提升性能。

預訓練與遷移學習模型預訓練(pre-training)任務,即將模型在⼤量數據上進⾏訓練,將訓練后的模型作為「起始點」,來幫助提升下游任務的性能。

作者們利⽤合成數據,對模型進⾏了預訓練,并對數據量、數據多樣性程度、預訓練模型結構和預訓練⽅法進⾏了實驗研究。

最終發現:

⽤合成數據進⾏預訓練。已經可以 達到甚⾄超越⽤真實數據預訓練的效果。 ⽤更⼤的數據量和數據多樣性的合成數據,可以獲得更好的預訓練效果。 從模型結構和預訓練⽅法來看,ViT-based模型(相比convolutional-based模型)、⾃監督⽅法(相比有監督⽅法)會更適合合成數據下的預訓練。

論文認為,利⽤⽣成模型產⽣的合成數據來幫助圖像分類任務是可行的,不過也存在⼀定的局限性。

例如,如何處理特定任務的domain gap和數據多樣性之間的trade-off,以及如何更有效地利⽤潛在⽆窮量的合成圖⽚⽤于預訓練,都是需要進一步去解決的問題。

[圖擷取自網路,如有疑問請私訊]

|

本篇 |

不想錯過? 請追蹤FB專頁! |

| 喜歡這篇嗎?快分享吧! |

相關文章

科普解密