首個3D人像視訊生成模型來了:僅需1張2D人像,眨眼、口型都能改變

只需1張普通照片,就能合成全角度動態3D視訊。

![]()

眨個眼、動動嘴,都是小case~

![]()

最近AIGC爆火,3D人像模型生成這邊也沒閑著。

如StyleNerf、StyleSDF、EG3D等方法相繼出世。

但到目前為止,這種生成模型都還停留在 單幀人像上。

最近,來自新加坡國立大學(NUS)和字節跳動的研究人員,在靜態3D模型的基礎上,提出了 首個3D人像視訊生成模型:PV3D(3D model for Portrait Video generation)。

![]()

PV3D的訓練繼承了3D GAN模型的優點,即 無需動態的三維數據監督,只需要在足夠數量的單視角2D視訊數據上進行訓練。

該生成框架將人像和動作進行解耦,基于視訊的時間戳生成各自的三維表征,讓視訊可以從任意角度進行渲染。

長視訊也能挑戰:

![]()

3D動態人像生成PV3D分別從獨立的高斯分布中采樣隨機噪聲來表征外表和運動,外表噪聲生成視訊的主體內容,控制人像的ID以及人臉的各個部分,運動噪聲配合視訊幀的時間戳控制當前幀的動作。

為了確保生成內容的真實性以及外表和運動的解耦, PV3D訓練兩個獨立的判別器分別判定外表和運動的合理性。

該方法可以生成隨機的人像視訊以及相應的高品質的動態幾何表面,讓視訊可以從任意角度進行渲染。

同時,該方法可以支持下游的應用任務,比如靜態人像驅動,人像視訊的重建以及對人像動作的修改,所有的結果均可以保持高的多視角一致性。

![]()

主流的3D GAN模型都脫胎于 StyleGAN結構。

因此這些模型均會將采樣得到的噪聲先映射到一個高維度的 中間隱式編碼(intermidate latent code),大量現有的研究表明這種結構的隱式空間包含了豐富的語義信息,可以用來控制生成的圖像內容。

因此,最直接的拓展方式就是使用預訓練的單幀3D GAN模型,通過學習一個額外的在隱式空間進行推理的時序模型對生成的內容進行合理的改變,從而生成3D人像視訊。

然而,該方法的缺點是圖片生成器和時序推理模型在不同的階段分別被優化,導致最終的視訊 很難保持時間上的一致性。

另一種主流的視訊生成模型使用 稀疏訓練的方式,在訓練階段直接隨機生成視訊中的少量幀,使用少數幀的時間戳編碼運動信息,進一步的改變中間隱式編碼從而一次性優化完整的生成器。

然而這種做法將全部的時序信息都包含在隱式空間中,導致最終的模型 多樣性較差、生成品質較低。

與上述方法不同,PV3D在原有GAN模型的基礎上在特定尺度的生成模塊中[插·入] 運動信息的編碼層,這些編碼層獨立地將控制運動的噪聲映射為 隱式編碼,使用modulated convolution操縱外表特征,再將操縱后的特征與原始特征融合,從而提高生成視訊的時序一致性和運動多樣性。

此外,本工作還研究了以下問題:

如何有效地在視訊生成任務中利用渲染的視角先驗信息

針對3D視訊生成,如何設計合理的外表和運動判別器

![]()

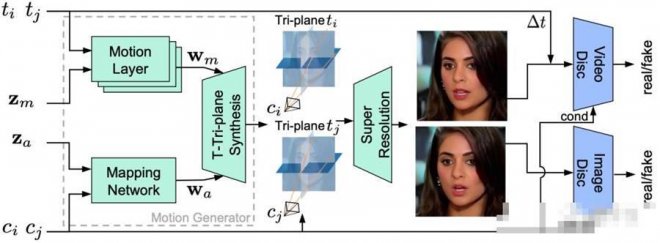

PV3D模型基于最新的靜態3D GAN模型EG3D進行開發,EG3D采用高效的3D表征Tri-plane實現圖像生成。

在訓練階段,PV3D采用稀疏訓練的策略,對于一個視訊采樣兩個噪聲、兩個時間戳以及各自時刻對應的相機視角。

相對應的,模型生成兩幀對應的3D表征進行渲染得到粗糙的結果。隨后使用超分辨率模塊將圖片上采樣。

PV3D設計了兩個獨立的判別器監督網絡的學習,其中視訊判別器會編碼兩幀的相機視角以及時間間隔去判斷生成結果的合理性。

實驗部分評價指標

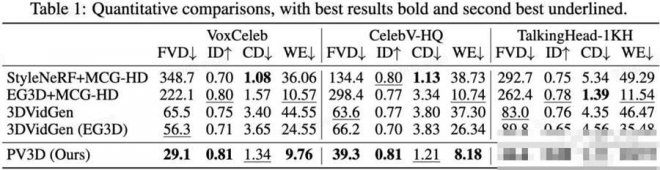

研究人員使用FVD來評估生成視訊的品質。此外,為了評估多視角的一致性以及3D幾何結構的品質,研究人員將3D GAN工作中常用的評價指標(生成人像的ID一致性、Chamfer距離、多視角的重投影誤差)拓展到視訊任務中。

與基線的對比

研究人員首先采用同期的3D視訊生成工作3DVidGen作為基線。此外,研究人員還基于SOTA的單幀3D GAN (EG3D和StyleNerf) 和2D視訊生成模型構建了三個基線模型。在3個公開數據集(VoxCeleb, CelebV-HQ, TalkingHead-1KH)上的實驗結果表明,PV3D在生成視訊的多樣性,3D幾何的品質,以及多視角一致性上均超越基線模型。

![]()

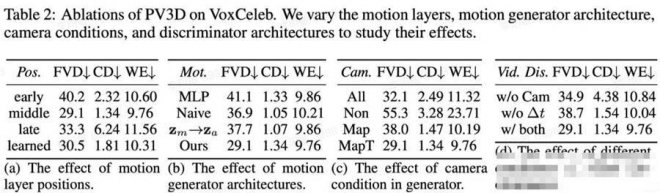

消融實驗

研究人員對PV3D的各部分設計進行了消融實驗,例如:運動信息的編碼和注入的位置,運動信息的[插·入]方式,相機視角的采樣策略,以及視訊判別器的設計。

![]()

[圖擷取自網路,如有疑問請私訊]

眨個眼、動動嘴,都是小case~

最近AIGC爆火,3D人像模型生成這邊也沒閑著。

如StyleNerf、StyleSDF、EG3D等方法相繼出世。

但到目前為止,這種生成模型都還停留在 單幀人像上。

最近,來自新加坡國立大學(NUS)和字節跳動的研究人員,在靜態3D模型的基礎上,提出了 首個3D人像視訊生成模型:PV3D(3D model for Portrait Video generation)。

PV3D的訓練繼承了3D GAN模型的優點,即 無需動態的三維數據監督,只需要在足夠數量的單視角2D視訊數據上進行訓練。

該生成框架將人像和動作進行解耦,基于視訊的時間戳生成各自的三維表征,讓視訊可以從任意角度進行渲染。

長視訊也能挑戰:

3D動態人像生成PV3D分別從獨立的高斯分布中采樣隨機噪聲來表征外表和運動,外表噪聲生成視訊的主體內容,控制人像的ID以及人臉的各個部分,運動噪聲配合視訊幀的時間戳控制當前幀的動作。

為了確保生成內容的真實性以及外表和運動的解耦, PV3D訓練兩個獨立的判別器分別判定外表和運動的合理性。

該方法可以生成隨機的人像視訊以及相應的高品質的動態幾何表面,讓視訊可以從任意角度進行渲染。

同時,該方法可以支持下游的應用任務,比如靜態人像驅動,人像視訊的重建以及對人像動作的修改,所有的結果均可以保持高的多視角一致性。

主流的3D GAN模型都脫胎于 StyleGAN結構。

因此這些模型均會將采樣得到的噪聲先映射到一個高維度的 中間隱式編碼(intermidate latent code),大量現有的研究表明這種結構的隱式空間包含了豐富的語義信息,可以用來控制生成的圖像內容。

因此,最直接的拓展方式就是使用預訓練的單幀3D GAN模型,通過學習一個額外的在隱式空間進行推理的時序模型對生成的內容進行合理的改變,從而生成3D人像視訊。

然而,該方法的缺點是圖片生成器和時序推理模型在不同的階段分別被優化,導致最終的視訊 很難保持時間上的一致性。

另一種主流的視訊生成模型使用 稀疏訓練的方式,在訓練階段直接隨機生成視訊中的少量幀,使用少數幀的時間戳編碼運動信息,進一步的改變中間隱式編碼從而一次性優化完整的生成器。

然而這種做法將全部的時序信息都包含在隱式空間中,導致最終的模型 多樣性較差、生成品質較低。

與上述方法不同,PV3D在原有GAN模型的基礎上在特定尺度的生成模塊中[插·入] 運動信息的編碼層,這些編碼層獨立地將控制運動的噪聲映射為 隱式編碼,使用modulated convolution操縱外表特征,再將操縱后的特征與原始特征融合,從而提高生成視訊的時序一致性和運動多樣性。

此外,本工作還研究了以下問題:

如何有效地在視訊生成任務中利用渲染的視角先驗信息

針對3D視訊生成,如何設計合理的外表和運動判別器

PV3D模型基于最新的靜態3D GAN模型EG3D進行開發,EG3D采用高效的3D表征Tri-plane實現圖像生成。

在訓練階段,PV3D采用稀疏訓練的策略,對于一個視訊采樣兩個噪聲、兩個時間戳以及各自時刻對應的相機視角。

相對應的,模型生成兩幀對應的3D表征進行渲染得到粗糙的結果。隨后使用超分辨率模塊將圖片上采樣。

PV3D設計了兩個獨立的判別器監督網絡的學習,其中視訊判別器會編碼兩幀的相機視角以及時間間隔去判斷生成結果的合理性。

實驗部分評價指標

研究人員使用FVD來評估生成視訊的品質。此外,為了評估多視角的一致性以及3D幾何結構的品質,研究人員將3D GAN工作中常用的評價指標(生成人像的ID一致性、Chamfer距離、多視角的重投影誤差)拓展到視訊任務中。

與基線的對比

研究人員首先采用同期的3D視訊生成工作3DVidGen作為基線。此外,研究人員還基于SOTA的單幀3D GAN (EG3D和StyleNerf) 和2D視訊生成模型構建了三個基線模型。在3個公開數據集(VoxCeleb, CelebV-HQ, TalkingHead-1KH)上的實驗結果表明,PV3D在生成視訊的多樣性,3D幾何的品質,以及多視角一致性上均超越基線模型。

消融實驗

研究人員對PV3D的各部分設計進行了消融實驗,例如:運動信息的編碼和注入的位置,運動信息的[插·入]方式,相機視角的采樣策略,以及視訊判別器的設計。

[圖擷取自網路,如有疑問請私訊]

|

本篇 |

不想錯過? 請追蹤FB專頁! |

| 喜歡這篇嗎?快分享吧! |

相關文章

科普解密